Ein kreativer und inspirativer Nachmittag im betahaus in der Schanze. Über die Nutzung von Künstlicher Intelligenz zur Generation von Text, Musik und Bildern. ChatGPT ist schließlich in aller Munde – und die Disruption nicht mehr aufzuhalten.

Der Nachmittag gliederte sich in drei Blöcke:

- Wo stehen wir? Ein kurzer DeepDive in Theorie und Wissenschaft von Werner Bogula vom Artificial Intelligence Center Hamburg (ARIC)

- Was können wir damit machen? Drei Masterclasses zur Nutzung von KI zur Generierung für Text (Dr. Jonathan Mall von neuroflash), Bild (Dr. Ayse Glass von der Hafencity Universtät) und Literatur (Sabrina Pohlmann vom ARIC)

- Und wo geht die Reise noch hin? Ein Impuls-Vortrag von Peter Kabel (Hochschule für Bildende Künste Hamburg) und vier seiner Studenten

Wo stehen wir heute und was ist eigentlich das Besondere an ChatGPT?

ChatGPT ist in der Lage ist, natürliche Sprache zu verstehen und darauf “menschenähnlich” zu reagieren, indem es kontextbezogene Antworten generiert. Indem es mit Benutzern interagiert und Feedback erhält, kann es lernen und sich verbessern. Im Vergleich zu früheren KIs zeichnet es sich aus durch

- Conversation Memory: heißt, wenn eine KI eine Konversation mit einem User führt, kann es sich an frühere Interaktionen erinnern, um die Kontinuität und Relevanz der aktuellen Konversation zu verbessern.

- Finetuned Model RLHF (= Response Language Model with Human Feedback): Werkzeug für Konversationsanwendungen, das auf Basis von Technologien wie Deep Learning und NLP (Natural Language Processing) entwickelt und speziell für die Erzeugung von Antworten in einer Konversationsanwendung trainiert wurde und dabei menschliches Feedback zur Verbesserung der generierten Antworten verwendet.

- Longterm Feedback: Die KI ist in der Lage auch nach diversen Schleifen den Request-Ursprung zu identifizieren und durch ein kollektives Gedächtnis immer weiter zu lernen.

Dahinter steht das Deep-Learning-Modell GPT (Generative Pre-trained Transformer). Dabei sind Transformer eine Art von neuronalen Netzen, die auf der Idee von “Aufmerksamkeit” basieren. Im Gegensatz zu früheren Modellen, die Eingaben in einer sequenziellen Reihenfolge verarbeiteten, können Transformer-Modelle kontextabhängige Ausgaben erzeugen, indem sie alle Elemente der Eingabe gleichzeitig berücksichtigen und die wichtigsten Informationen priorisieren.

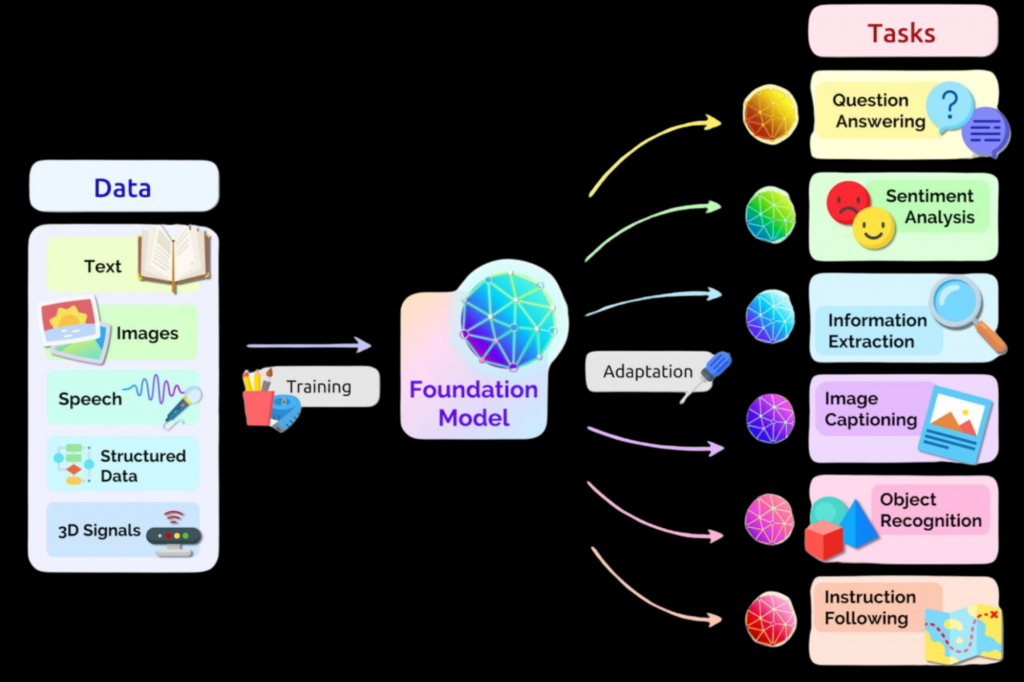

Foundation Models wie GPT-3 (Generative Pre-trained Transformer 3) und auch das Google Pendant BERT (Bidirectional Encoder Representations from Transformers) sind riesige Transformer-Netzwerke, die auf großen Textmengen vortrainiert wurden. Diese Modelle können dann auf bestimmte Aufgaben feinabgestimmt werden, indem sie zusätzliche Daten und Anweisungen erhalten.

Zusammengefasst sind Foundation Models:

- riesige Bedeutungsspeicher im Sinne eines kollektiven Gedächntnisses

- die das “Rechnen” mit und das “Generieren” von Bedeutung ermöglichen

- und vor allem für jede/n ohne Vorwissen durch Prompting verfügbar sind

Was können wir damit machen?

Im zweiten Masterclass-Teil ging es um die praktische Anwendung und das unfassbar breite Tooling-Set. Daher hier nur eine kleine Auswahl der unterschiedlichen Tools und Anwendungsmöglichkeiten:

- DALL·E 2 (OpenAI) für KI Bilder

- Midjourney für KI Bilder

- Ebenso für Bildgenerierung Dreamstudio.ai und Stable Diffusion. Da Open Source kommen sie mit vielen interessanten Plugins, z.B. Instruct pix2pix, Controlnet

- Synthesia für Video KI

- Runway Gen 2 für Video KI

- Cogniwerk.so als Community mit verschiedenen trainierten AI models für Kreative

- Neuroflash.ai als KI Texter

- Aleph Alpha als deutsches Pendant zu ChatGPT

- Google’s MusicLM – aus Text wird Musik

Ein erstes Ergebnis aus der Anwendung der Tools seht ihr in diesem Post (Ratespielchen: welche Teile sind KI generiert und welche aus dem Vortrag?) und natürlich das KI generierte Beitragsbild.

Und wo geht die Reise noch hin?

Es ist so offensichtlich und doch noch so unfassbar – die KI wird alle kreativen Berufe revolutionieren. Vom Architekten, zum Fotografen, vom UX Designer zum Musikproduzenten, vom Product Manager zum Regisseur. Am schnellsten aber wohl alle Berufe rund um die die Texterstellung – Kundenservice, Redaktionen und Content Creatoren im allgemeinen.

Der neue Skill heißt: Prompt Crafting. Lerne die KI zu nutzen durch geschickte Auswahl und Kombination von Sprachbefehlen. Hierzu nutze die Pro’s selbst kreierte Prompt Tabellen – die natürlich streng geheim und letztlich die kreative Kraft sind.

Eine Sprachmethodik hat sich hierbei aber wohl bewährt:

[format] of [subject term], a [solidifier], [perspective], by [artist:75] by [artist:25]/ in the style of [style], [variant], [booster], [exclusion]

als Beispiel:

photograph of a space whale, a whale in space, through a porthole, by alphonse mucha:75 by andy warhol:25, control the soul, trending on artation ~no plants

Die Kreativitätsleistung verschiebt sich also, neue Fähigkeiten werden immer wichtiger:

- Vorbereiten und Selektion von Trainingsdaten

- Methodisches Prompt Crafting

- Chaining – Aufbau einer eigenen Tool/Prozess Pipeline

- Packaging von Text, Visuals, Layoutund Code

Ein insgesamt inspirierender und erkenntnisreicher Tag, ausgerichtet vom Artificial Intelligence Center Hamburg (ARIC), ein Verein zur Förderung und Nutzung von KI in der Metropolregion Hamburg. Vielen Dank dafür!